神经网络加速器,加速AI时代

据悉,先进视觉影像SoC应用技术领导厂商Socionext Inc.(以下“索喜科技”或“公司”)宣布推出神经网络加速器 (Neural Network Accelerator engine,缩写NNA),用于优化人工智能处理中的边缘计算设备。它具备高速且低功耗的特性,是专用于深度学习中推理处理的加速器。相较以往的处理器,NNA在图像识别等处理时性能提升约100倍。公司预计于2018年第三季度开始,配合FPGA软件开发工具提供产品销售。此外,搭载有NNA的SoC产品开发也正在规划当中。

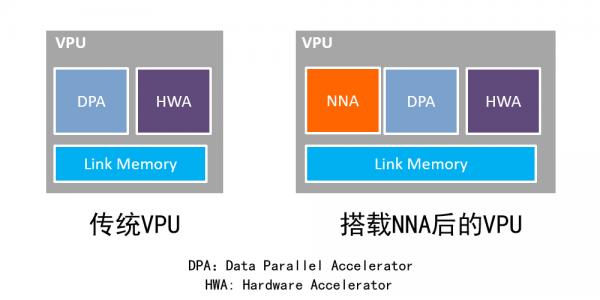

随着消费电子、汽车电子、工业控制等越来越多的应用引入人工智能(AI),人工智能面临着前所未有的快速发展,深度学习、神经网络等技术迎来了发展高潮。神经网络越大,需要的计算量就越大,传统的VPU虽然也能完成人工智能运算,但因为高功耗和高延迟已经略显疲惫。在VPU上加载人工智能计算能力则可以规避这些问题,而且具有更高的可靠性。

Socionext目前提供图像处理SoC“SC1810”,这款芯片内置有技术标准化组织Khronos Group制定的API规范-OpenVX,内置有视觉处理器(VPU,Vision Processor Unit)。此次新推出的NNA加速器能VPU性能,可在汽车、数字标牌等多种应用中通过深度学习及传统的影像识别执行多种电脑视觉处理,以便在较低功耗下提供更高的性能。

NNA采用量化技术整合了公司的专有构架,减少了深度学习所需的参数和激活值。通过量化技术能以较少的资源执行大量计算任务,大幅减少数据量,并显著降低系统存储器带宽。此外,新开发的片上存储器电路设计提高了深度学习所需的计算资源效率,能在非常小的封装中实现最佳性能。搭载有NNA的VPU结合了最新的技术,能在图像识别处理时比传统VPU快100倍。

Socionext预计于2018年第三季度开始提供NNA FPGA软件开发包。改软件开发包可支持TensorFlow学习环境,并提供用于量化技术的专用库和从学习模型到推论处理用的数据转换工具。通过利用NNA优化后的学习环境,用户无需模型压缩或学习调谐(learning tuning)知识也能有效建立起他们自己的模型。今后Socionext还将计划通过支持各种深度学习框架来支持应用广泛的开发环境,让用户能简单建立深度学习的应用程序。

与此同时,Socionext也计划将载有NNA的SoC芯片投入市场。目标应用包括车载系统中的影像拍摄,以及基于行人、自行车等高精度物体识别的辅助驾驶以及自动泊车。另一个重要的应用便是显示系统,例如电视、数字标牌,NNA可在超分辨率处理时增强图像识别,提高4K/8K屏幕高清晰度成像。Socionext将不断创新并开发出高效、高性能产品,以适应各种边缘计算环境中广泛的AI应用。

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

即日-6.18立即报名>> 【在线会议】英飞凌OBC解决方案——解锁未来的钥匙

-

精彩回顾立即查看>> 【在线研讨会】普源精电--激光原理应用与测试解决方案

-

精彩回顾立即查看>> 【在线会议】汽车腐蚀及防护的多物理场仿真

-

精彩回顾立即查看>> 【在线会议】汽车检测的最佳选择看这里

-

精彩回顾立即查看>> 2024工程师系列—工业电子技术在线会议

推荐专题

- 1 最强国产X86 CPU曝光:128核,512线程,性能直追intel/AMD

- 2 联想开天N8 Pro笔记本评测:移动版兆芯KX-7000效率甚至优于Intel/AMD

- 3 微星泰坦16 AI 2025评测:顶级性能 轻薄本续航

- 4 AMD RX 9070 GRE首发评测

- 5 技嘉B850M AORUS PRO WIFI7电竞雕主板评测

- 6 技嘉RTX 5060小雕首发评测:超越RTX 4060 Ti!2K也有一战之力

- 7 技嘉RTX 5070 Ti超级雕评测

- 8 酷睿Ultra 9 275 HX与i9-14900HX深度对比!联想拯救者Y9000P 2025至尊版评测

- 9 影驰RTX 5060 Ti金属大师白金版16GB MAX OC评测

- 10 智能硬件C端承压,科大讯飞的困局与隐忧

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论